Την ώρα που η Ελλάδα ετοιμάζεται να κάνει τα δικά της δειλά βήματα στον θαυμαστό καινούργιο κόσμο της Τεχνητής Νοημοσύνης, η άποψη ότι οι αλγόριθμοι είναι ουδέτεροι δείχνει να καταρρίπτεται. Είναι τελικά η Τ.Ν προκατειλημμένη; Κι αν ναι «τις πταίει» και τι προβλήματα δημιουργεί η συνθήκη αυτή;

Η τεχνητή νοημοσύνη «δεν έχει πονοκέφαλο, δεν είναι αδιάθετη, δεν έχει τσακωθεί με τον/την σύντροφό της, δεν έχει διαπληκτιστεί με τον οδηγό άλλου αυτοκινήτου, δεν αντιπαθεί τις μειονότητες και για να το φέρουμε στην πιο πρόσφατη εκδοχή του, δεν είναι υπέρ ή κατά των εμβολίων». Οι παραπάνω είναι μόνο μερικοί από τους λόγους που η σύγχρονη αυτή τεχνολογία, η οποία εξελίσσεται με ταχύτατους ρυθμούς, παράγοντας από αυτόνομα αυτοκίνητα έως αυτοματοποιημένους «δικαστές», έχει καθιερωθεί στην συλλογική συνείδηση ως ουδέτερο, αμερόληπτο και χωρίς προκαταλήψεις δημιούργημα. Η προαναφερθείσα αντίληψη βέβαια έχει αρχίσει να καταρρίπτεται και όσο η χρήση της Τ.Ν. διευρύνεται, η κατάφαση γίνεται ερώτηση και συνοψίζεται κάπως έτσι: είναι πράγματι η Τ.Ν. αμερόληπτη; Όσο για την απάντηση, σε γενικές γραμμές είναι «όχι», γεγονός που επισφραγίζουν πολυάριθμες έρευνες και μαρτυρίες.

Οι προκαταλήψεις της Τεχνητής Νοημοσύνης

Ήδη από το 1988, η Επιτροπή Κατά των Φυλετικών Διακρίσεων της Μ. Βρετανίας, κατηγόρησε την Βρετανική Ιατρική Σχολή St. George για διακρίσεις. Συγκεκριμένα, ο αλγόριθμος που είχε αναπτύξει καθηγητής της σχολής για να επιταχύνει τη διαδικασία της αρχικής επιλογής των δυνητικών σπουδαστών, ανακαλύφθηκε ότι μεροληπτούσε έναντι γυναικών και άλλων υποψηφίων των οποίων το όνομα δεν ήταν και τόσο «ευρωπαϊκό». Παρόλα αυτά το πρόγραμμα ήταν αρκετά ακριβές – κατά την δοκιμαστική του εφαρμογή το 90%-95% των αποφάσεων που έπαιρνε συνέπιπταν με τις αποφάσεις των μελών της επιτροπής που έτρεχε μέχρι τότε την διαδικασία. Το σύστημα δηλαδή πετύχαινε το στόχο, μείωνε πράγματι τον όγκο δουλειάς, απλά αναπαρήγαγε τις προκαταλήψεις των καθηγητών.

Σχεδόν 30 χρόνια αργότερα, η χρήση των αλγορίθμων και της τεχνητής νοημοσύνης έχει αυξηθεί αισθητά, το ίδιο και οι σχετικές με τις διακρίσεις προκλήσεις.

Σύμφωνα με δημοσιογραφική έρευνα της ProPublica, ο αλγόριθμος ποινικής δικαιοσύνης που χρησιμοποιείται στη Φλόριντα και σε άλλες αμερικανικές πολιτείες για να προβλέψει την επικινδυνότητα όσων συλλαμβάνονται, είναι «υπέρμαχος» των φυλετικών διακρίσεων. Για την ακρίβεια κρίνει τους αφροαμερικανούς κατηγορούμενους «υψηλού κινδύνου» δύο φορές περισσότερο από ότι τους «λευκούς κατηγορούμενους». Ο λόγος είναι και εδώ απλός: γιατί βασίζεται σε προγενέστερες αποφάσεις που πράγματι χαρακτηρίζονταν από διακριτική φυλετική μεταχείριση.

Σε αντίστοιχα συμπεράσματα καταλήγει κι άλλη έρευνα για τους αλγόριθμους ενσωμάτωσης κειμένου και τα μοντέλα επεξεργασίας της φυσικής γλώσσας. Κάπως έτσι, την ώρα που οι προσπάθειες για την αύξηση του αριθμού των γυναικών σε θέσεις ανώτατων στελεχών διευρύνονται, αν κάποιος πληκτρολογήσει την λέξη CEO σε ένα iOS smartphone η εικόνα με την οποία αντιστοιχίζεται η λέξη, θα είναι ενός άντρα επιχειρηματία. Αντίστοιχα οι αλγόριθμοι ταξινόμησης εικόνας στην Apple και την Google εξακολουθούν να εμπεριέχουν ρατσιστικές αλληγορίες .

Επιπλέον, κατά το Google Translate «doctor» είναι γιατρός ενώ «nurse» είναι νοσοκόμα κι όχι νοσοκόμος. Στην τουρκική γλώσσα μάλιστα η μεροληψία εντείνεται, γιατροί και πρόεδροι είναι ανδρικού φύλου ενώ νοσηλευτικό προσωπικό και εκπαιδευτικοί είναι γυναικείου. Ακόμα χειρότερα υπάρχει ο σκληρά εργαζόμενος (άντρας) και η τεμπέλα (γυναίκα) ή ο προγραμματιστής και η νοικοκυρά.

“Το 2018 η Amazon κατήργησε το ΑΙ σύστημα που χρησιμοποιούσε για τις προσλήψεις εργαζομένων, αφότου διαπιστώθηκε ότι έδινε προβάδισμα σε βιογραφικά αντρών που εμπεριείχαν συνηθέστερα λέξεις όπως «executed» ή «captured».”

Τον κώδωνα του κινδύνου για τις προκαταλήψεις των αλγορίθμων έκρουσε προ τριετίας και η ερευνήτρια για την ηθική της Τ.Ν. στην Google, Timnit Gebru. Η Gebru ζητούσε από τους ανώτερούς της να προβούν σε περισσότερες προσλήψεις ανθρώπων που ανήκουν σε μειονότητες, κάνοντας λόγο για σοβαρές μεροληψίες στους αλγόριθμους της εταιρείας. Το email είχε σταλεί κατόπιν σχετικής μελέτης που πραγματοποίησε μαζί με τέσσερις συναδέλφους της. «Υπάρχουν πάρα πολύ μεγάλες πιθανότητες να εκπαιδεύουμε τις μηχανές να μεροληπτούν», συμπέρανε η έρευνα, «καθώς τις ταΐζουμε με άφθονα μεροληπτικά δεδομένα».

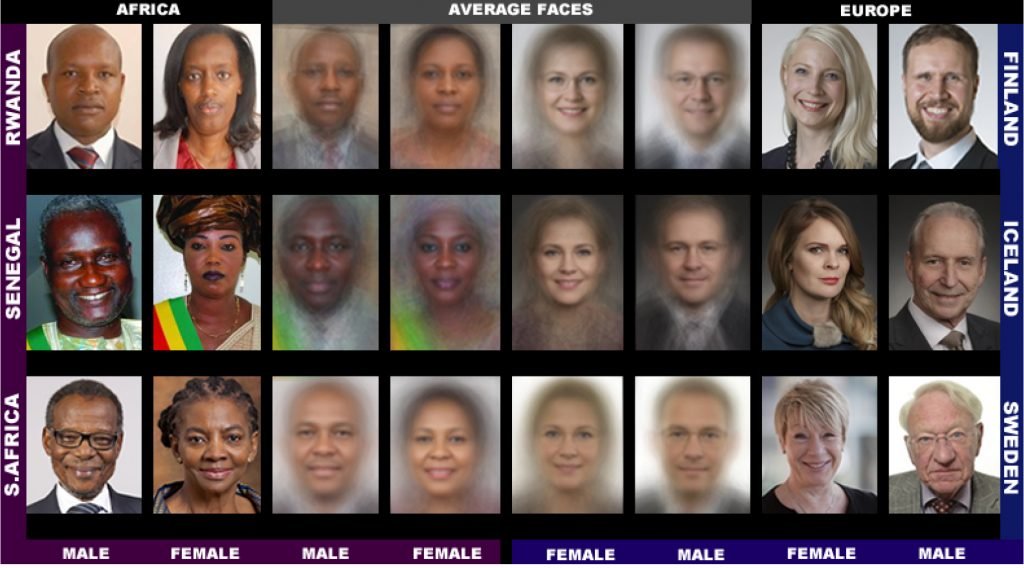

Αντίστοιχα, σε μεροληπτικούς αλγορίθμους μπορεί να οδηγήσει ακόμα και η τροφοδότηση τους με δεδομένα στα οποία συγκεκριμένα γκρουπ ανθρώπων υποεκπροσωπούνται ή υπερεκπροσωπούνται. Έρευνα που έκανε ο Joy Buolamwini σε συνεργασία με την Timnit Gebru στο MIT εντόπισε ότι οι τεχνολογίες αναγνώρισης προσώπου παρουσιάζουν μεγαλύτερα ποσοστά λάθους σε γυναίκες που ανήκουν σε μειονότητες, πιθανότατα λόγω έλλειψης αντιπροσωπευτικών δεδομένων.

Σχετική έρευνα διεξήγαγε και το National Institute of Standards and Technology (NIST). Σε αυτή αξιολογήθηκαν οι αλγόριθμοι αναγνώρισης προσώπου από περίπου 100 προγραμματιστές και 189 εταιρείες, συμπεριλαμβανομένων των Toshiba, Intel και Microsoft.

Μιλώντας για τα συμπεράσματα της μελέτης ένας εκ των συγγραφέων αυτής, ονόματι Patrick Grother, ανέφερε: «εντοπίσαμε την ύπαρξη δημογραφικών διαφοροποιήσεων στην πλειονότητα των αλγορίθμων που μελετήσαμε». Στη συνέχεια μάλιστα εξηγούσε: Οι αλγόριθμοι αναγνώρισης προσώπου έκαναν περισσότερα λάθη όταν κλήθηκαν να αναγνωρίσουν την εικόνα ενός Ασιάτη κι ενός Αφροαμερικανού. H ακρίβεια ήταν χειρότερη όταν επρόκειτο για Αφροαμερικανές αντί Αφροαμερικανούς. Παράλληλα, τα λάθη που εντοπίζονταν κατά την αναγνώριση προσώπου Ασιατών, Αφροαμερικακών και μειονοτήτων ήταν αριθμητικά περισσότερα σε αλγόριθμους που είχαν αναπτύξει Αμερικανοί. «Παρότι δεν εξετάζουμε τι μπορεί να προκαλεί αυτές τις διαφοροποιήσεις, τα δεδομένα παραμένουν χρήσιμα τόσο για τους προγραμματιστές όσο και για τους χαράσσοντες πολιτική, αφού αποδεικνύουν τους περιορισμούς και τα λάθη στη χρήση τέτοιων συστημάτων συμπλήρωνε ο Grother.

Κι όμως δεν είναι οι αλγόριθμοι προκατειλημμένοι

«Η ιδέα του ότι η μηχανή παίρνει πιο αντικειμενικές αποφάσεις γιατί δεν επηρεάζεται από τις προϊδεάσεις που έχει ένας άνθρωπος έχει συζητηθεί πολύ και υποστηρίζεται κατά μία έννοια ακόμα και σήμερα. Πρόσφατα για παράδειγμα μια σουηδική κοινότητα «ανέθεσε» σε ένα ρομποτικό σύστημα να πραγματοποιεί τις αρχικές συνεντεύξεις υποψηφίων για θέσεις διοικητικού προσωπικού. Η τελική επιλογή θα γινόταν από τους εργαζόμενους του τμήματος HR. Η σκέψη ήταν ότι το σύστημα θα κάνει τις συνεντεύξεις χωρίς να επηρεάζεται από το φύλο, το ντύσιμο του υποψηφίου, την στάση του σώματος κ.ά., κάτι που ο άνθρωπος θα μπορούσε υποσυνείδητα να λαμβάνει υπόψιν. Σε αυτό το παράδειγμα η επιλογή δεν ενέχει κάποια προκατάληψη, άρα το μηχάνημα θα είναι πιο αντικειμενικό» αναφέρει η Λίλιαν Μήτρου, καθηγήτρια του Πανεπιστημίου Αιγαίου και πρόεδρος του Ινστιτούτου για το Δίκαιο Προστασίας της Ιδιωτικότητας, των Προσωπικών Δεδομένων και την Τεχνολογία.

«Ωστόσο, το να θεωρούμε ότι ένα μηχάνημα είναι εξ ορισμού αντικειμενικό είναι λάθος, εφόσον όλα τα συστήματα που επεξεργάζονται ένα σετ δεδομένων έχουν έναν τρόπο εκπαίδευσης και “σκέψης”» συμπληρώνει. «Θα πρέπει να δει κανείς ποιος είναι ο στόχος που τους τίθεται, τι διεργασία ακολουθείται, ποια είναι τα δεδομένα με τα οποία τροφοδοτούνται και ποιο το μοτίβο με το οποίο προγραμματίζονται να τα συσχετίζουν. Όλα τα παραπάνω είναι ανθρώπινη απόδοση. Άρα λοιπόν δεν είναι οι αλγόριθμοι προκατειλημμένοι, τα δεδομένα και οι διεργασίες για την επεξεργασία τους μπορεί να είναι. Δεν πρέπει να ξεχνάμε ότι ο αλγόριθμος προσανατολίζεται, βασιζόμενος στη δική μας πρόσληψη της πραγματικότητας» τονίζει.

Το πρόβλημα του «μαύρου κουτιού»

Το πρόβλημα της μεροληψίας άλλωστε είναι γνωστό αλλά όχι μείζον, σύμφωνα με την ίδια. «Μείζον πρόβλημα της τεχνητής νοημοσύνης είναι η έλλειψη διαφάνειας, η ικανότητα δηλαδή του να μπορέσουμε να αποκαταστήσουμε την ροή της σκέψης. Αυτό δεν μπορεί να γίνει στο 100% ούτε στην περίπτωση του ανθρώπου, γιατί ακόμα και η πιο λογική διεργασία έχει ένα στοιχείο προϊδέασης. Για παράδειγμα εμένα δεν μου αρέσει το επίθετό σας (Παπάζογλου) γιατί έχω στο πίσω μέρος του μυαλού μου ότι είναι τουρκικής προελεύσεως» εξηγεί η κα Μήτρου. «Στην περίπτωση όμως που μια απόφαση λαμβάνεται από μια μηχανή το πρόβλημα είναι ακόμα σοβαρότερο, γιατί οι προκαταλήψεις είναι αδιαφανείς και δεν γνωρίζουμε πώς ένα σετ δεδομένων κατέληξε να πάρει μια απόφαση, η οποία ενέχει προκατάληψη».

«Αυτό με την σειρά του δυσκολεύει την διαδικασία αμφισβήτησης», συμπληρώνει. «Η αιτιολογία που υπάρχει κυρίως σε δύο πολύ κομβικές λειτουργίες του δημόσιου τομέα, στη Διοίκηση και την Δικαιοσύνη, δίνει εξηγήσεις για το πώς θεμελιώνεται μια απόφαση, πώς δηλαδή εκτίμησε κανείς τα στοιχεία και με ποια διεργασία, με ποιες αρχές κατέληξε σε ένα κάποιο συμπέρασμα. Και η αιτιολογία είναι απαραίτητη αρχικά για να καταλάβει κανείς την απόφαση και στη συνέχεια για να μπορεί να την αμφισβητήσει και να προσφύγει κατά αυτής, υποστηρίζοντας ότι ο συλλογισμός της έχει σφάλμα. Αν δεν μπορώ να δω τι έχει συμβεί, είναι δύσκολο και να το αμφισβητήσω. Στον αντίποδα, το ποιόν βαραίνει η ευθύνη μιας απόφασης από σύστημα τεχνητής νοημοσύνης, θεωρείται λυμένο πρόβλημα, αφού έχει αποφασιστεί ότι η ευθύνη μένει στην διοίκηση. Αν για παράδειγμα ένα σύστημα ΤΝ έκρινε κάποιον ύποπτο για φοροδιαφυγή, το πρόβλημα είναι ότι δεν μπορεί να αιτιολογήσει για ποιο λόγο κατέληξε στην απόφαση. Το κατά ποιου θα προσφύγει αυτός ο κάποιος αν θελήσει να την αμφισβητήσει είναι απλό, κατά της αρμόδιας αρχής του υπουργείου Οικονομικών».

“Κι εδώ όμως ξεκινά μια άλλη συζήτηση ως προς το τι σημαίνει εξήγηση. Να επισημάνω για παράδειγμα ότι οι αθωωτικές αποφάσεις ποινικών δικαστηρίων στην Ελλάδα δεν έχουν αιτιολογία, δεν βγαίνει δηλαδή συχνά ο δικαστής να αιτιολογήσει γιατί αθώωσε κάποιον. Κι αυτό είναι μόνο ένα παράδειγμα. Υπάρχουν πολλά αντίστοιχα παραδείγματα και στη δημόσια διοίκηση και στο σύστημα δικαιοσύνης. Αυτό δεν σημαίνει ότι υπερασπίζομαι το να υπάρχουν αδιαφανείς διαδικασίες. Ωστόσο η συζήτηση που πρέπει να κάνουμε θα πρέπει να αφορά και στον βαθμό της εξηγησιμότητας που απαιτούμε σε μια απόφαση, ο οποίος θα πρέπει να συγκρίνεται και με τα παρόντα δεδομένα» σημειώνει.

Ακαμψία και παγίωση του… παρελθόντος

Ένα άλλο βασικό πρόβλημα που εντοπίζεται ακριβώς επειδή η τεχνητή νοημοσύνη χρησιμοποιείται στη διοίκηση, την δικαιοσύνη ή ακόμα και στον ιδιωτικό τομέα είναι η ακαμψία, η επανάληψη του παρόντος και του παρελθόντος στο μέλλον. «Για παράδειγμα το σύστημα Compas δεν διαιωνίζει απλά μια προκατάληψη, διαιωνίζει την αντίληψη αυτής και δημιουργεί μια νέα αντικειμενική πραγματικότητα ίδια με την προηγούμενη. Αυτό στην περίπτωση της δικαιοσύνης γίνεται ακόμα χειρότερο.”

“Αν λείψει από την δικαιοσύνη το ανθρώπινο κομμάτι της νόησης και απλά βασίζομαι σε παλαιότερες αποφάσεις, θα αδυνατώ να γνωμοδοτήσω για κάτι καινούργιο, να έχω μια ρήξη με το παρελθόν και να υπάρξει τελικά πρόοδος” – Λίλιαν Μήτρου

«Για να φέρω ένα παράδειγμα, υπήρξε παλαιότερα η περίφημη απόφαση του ΕΣΡ η οποία υποστήριζε ότι το ομοφυλοφιλικό φιλί σε μια σειρά του Παπακαλιάτη προκαλούσε την δημόσια αιδώ. Η εν λόγω απόφαση πήγε στο Συμβούλιο της Επικρατείας και ακυρώθηκε. Η απόφαση πέρασε μέσα από το φίλτρο του δικαστή το οποίο έλεγε ότι η κοινωνία έχει αλλάξει κι έτσι υπήρξε η ρήξη που μας πήγε μπροστά. Αυτό το στοιχείο της παγίωσης του παρελθόντος είναι μεγαλύτερο πρόβλημα από την προκατάληψη, αφού γεννά μια στασιμότητα στα υφιστάμενα» καταλήγει.

Για «κρυστάλλωση» της νομολογίας κάνει λόγο και ο κ. Καρκατζούνης υπογραμμίζοντας μάλιστα ότι η χρήση ενός σχήματος μηχανικής μάθησης ειδικά στους τομείς των κοινωνικών επιστημών θα πρέπει να προϋποθέτει την επανεκπαίδευση και επικαιροποίηση του με τον ίδιο δυναμικό τρόπο που εξελίσσεται και η κοινωνία. Ταυτόχρονα βέβαια επισημαίνει και την δυσκολία του όλου εγχειρήματος. «Έστω ότι τραβάμε μια γραμμή και αρχίζουμε να εκπαιδεύουμε σήμερα έναν αλγόριθμο. Δεδομένου ότι η μηχανική μάθηση είναι εξελιγμένη στατιστική, ένα βασικό σκέλος του αλγορίθμου θα κληθεί να επαναλαμβάνει αποφάσεις που έχουν προκριθεί ως οι καλύτερες, κάτι δηλαδή που στις κοινωνικές επιστήμες είναι πολύ δύσκολο να οριστεί. Η χρήση τεχνητής νοημοσύνης σε ένα εργοστάσιο για την βελτιστοποίηση της παραγωγής μπορεί να μετρηθεί ποσοτικά και ποιοτικά. Πώς όμως ορίζεται μια σωστή δικαστική απόφαση; Είναι μια απόφαση που αποκαθιστά το κοινό περί δικαίου αίσθημα, δηλαδή μια εξαντλητική ποινή για ένα ειδεχθές έγκλημα, ή μια αποκαταστατική ποινή που θα έδινε την ευκαιρία σε κάποιον να επανέλθει; Υπάρχουν πολλοί παράγοντες που μπορούν να κρίνουν ένα αποτέλεσμα ως θετικό ή αρνητικό, γεγονός που κάνει τα πράγματα ακόμα πιο ρευστά».

Βαδίζοντας προς την Εθνική Στρατηγική για την ΤΝ

Οι προαναφερθέντες προβληματισμοί έρχονται στο προσκήνιο όλο και περισσότερο, δεδομένης της αύξησης της χρήσης της Τ.Ν στον Δημόσιο τομέα. Κι αν οι σχετικές λειτουργίες στην Ευρώπη – παρότι φειδωλά και σε μεμονωμένες περιπτώσεις, έχουν ξεκινήσει ήδη από το 2019, στην Ελλάδα η συζήτηση αρχίζει τώρα. Η αφορμή είναι η Εθνική Στρατηγική για την Τεχνητή Νοημοσύνη, η οποία αναμένεται να δημοσιοποιηθεί στα μέσα Οκτωβρίου και τα σχετικά με την Τ.Ν. έργα που περιλαμβάνονται στη Βίβλο Ψηφιακού Μετασχηματισμού.

Να θυμίσουμε ότι η Εθνική Στρατηγική για την Τ.Ν. είναι ένα πλαίσιο πολιτικής για την ανάπτυξη και εφαρμογή της τεχνητής νοημοσύνης στην Ελλάδα, το οποίο θα δομηθεί σε ένα σύνολο συντονισμένων και αλληλένδετων δράσεων. Η στρατηγική δηλαδή θα έρθει να καθορίσει τις προϋποθέσεις ανάπτυξης και τις εθνικές προτεραιότητες ώστε να ακολουθήσουν δράσεις ,όπως η ανάπτυξη μηχανισμών για την αντιμετώπιση της φοροδιαφυγής και για τον έλεγχο των δημοσίων συμβάσεων, η αυτόματη κωδικοποίηση της νομοθεσίας και άλλα. Στόχος σύμφωνα με τον υπουργό Ψηφιακής Διακυβέρνησης, κ. Κυριάκο Πιερρακάκη, είναι να υπάρξει μια τουλάχιστον πιλοτική εφαρμογή ανά τομέα άσκησης πολιτικής.

Ο στόχος βέβαια για να επιτευχθεί προϋποθέτει την ύπαρξη συγκεκριμένων παραμέτρων. «Για να συζητάμε για τεχνητή νοημοσύνη προϋπόθεση είναι η ψηφιοποίηση. Για παράδειγμα αν πείτε σε έναν μέσο δικηγόρο που πηγαίνει στην Ευελπίδων ότι θα χρησιμοποιηθούν συστήματα τεχνητής νοημοσύνης στο δικαστικό σύστημα θα σας απαντήσει ότι ακόμα δεν μπορεί να πάρει ψηφιακό αντίγραφο της απόφασής του, πώς μπορούμε λοιπόν να συζητάμε για κάτι τόσο εξελιγμένο όταν δεν έχουμε τα στοιχειώδη» αναφέρει σχετικά ο κ. Καρκατζούνης.

Όσο για την επιστημονική επιτροπή του ελληνικού υπουργείου Δικαιοσύνης για τις επιπτώσεις της Τεχνητής Νοημοσύνης στο δικαστικό σύστημα εξηγεί ότι αυτό που συζητείται περιορίζεται στο «αν υπάρχουν εν τέλει τομείς στο σύστημα δικαιοσύνης στο οποίο οι αλγόριθμοι θα μπορούσαν να λειτουργήσουν επικουρικά, ούτε καν με ημιαυτοποιημένες λύσεις στη λήψη αποφάσεων, όπως το να συμβάλλουν στην κωδικοποίηση της νομοθεσίας. Σημειωτέον ότι η χώρα μας αποτελεί μια από τις ελάχιστες της ΕΕ που δεν έχει κωδικοποιημένο δικαστικό σύστημα, δηλαδή ένας Έλληνας πολίτης δεν έχει πρόσβαση στην ψηφιοποιημένη μορφή του ποινικού κώδικα» τονίζει.

Βάσει των παραπάνω ο χρόνος για την υιοθέτηση της Τ.Ν. Στο Δημόσιο και στο δικαστικό σύστημα φαντάζει προαπαιτούμενο. Ακόμα κι αν χρειαστεί χρόνος όμως, οι αλλαγές θα έρθουν. «Εγώ δεν μπορώ να σκεφτώ καμία διαφορετική οπτική εξέλιξης της κοινωνίας σε 40-50 χρόνια από σήμερα. Η δομή των κοινωνιών μάλιστα είναι τέτοια που στο τέλος της ημέρας η πλειονότητα των αποφάσεων θα λαμβάνεται αλγοριθμικά. Οπότε το ζήτημα είναι πώς γίνεται η μετάβαση, ούτως ώστε να προχωρήσουμε σταδιακά και με μια λογική διαχείρισης ρίσκου, να ξεκινήσει δηλαδή από περιοχές που φαίνονται λιγότερο ριψοκίνδυνες ώς προς τα δικαιώματα των πολιτών.

Η συζήτηση για την ουδετερότητα της τεχνητής νοημοσύνης είναι μια ενδοσκόπηση

Οι προκαταλήψεις της ΤΝ έχουν σίγουρα ανθρώπινες προεκτάσεις, μεταφέρονται δηλαδή από τον φυσικό κόσμο στον ψηφιακό. Αρκεί να σκεφτεί κανείς ότι την ώρα που τη συζήτηση απασχολούν οι μεροληψίες τέτοιων συστημάτων έναντι Αφροαμερικανών και Ασιατών, τα αυτοκόλλητα επιθέματα, γνωστά κι ως χανσαπλάστ, κυκλοφορούν στο «χρώμα του δέρματος» παρότι η κλίμακα του Fitzpatrick (σ.σ. για το πόσο επηρεάζει η έκθεση στον ήλιο τα διαφορετικά χρώματα δέρματος) περιλάμβανε ήδη από το 1975 έξι δερματικές αποχρώσεις…

Αυτός είναι ίσως και ο λόγος που στο τέλος της ημέρας η συζήτηση για την μεροληψία της Τεχνητής Νοημοσύνης μοιάζει με αυτοκριτική, με ενδοσκόπηση, όπως επισημαίνει ο κ. Καρκατζούνης. «Πιθανότατα αν κοιταχτούμε με ειλικρίνεια όλοι στα μάτια θα πούμε ότι δεν είμαστε ικανοποιημένοι ούτε με το κοινωνικό, ούτε με το δικαστικό μας σύστημα ώστε να το περάσουμε σε έναν αλγόριθμο που θα το εφαρμόσει εσαεί και απόλυτα. Είναι αδύνατο να πούμε ότι είμαστε ικανοποιημένοι σε τέτοιο βαθμό οπότε ας κάνουμε outsource την διαδικασία σε μια μηχανή κι ας την αφήσουμε να αποδίδει δίκαιο. Στην αντίπερα όχθη όμως, θα πρέπει να συγκρίνουμε ρεαλιστικά πράγματα. Δεν μπορούμε να συζητάμε για ένα ιδανικό σύστημα δικαιοσύνης και δημόσιας διοίκησης, ειδικά στην Ελλάδα. Θα πρέπει να δούμε πώς οι παθογένειες που ήδη υπάρχουν θα μπορούσαν να αντιμετωπιστούν και με την χρήση εργαλείων μηχανικής μάθησης. Ότι οι λύσεις από την τεχνολογία δεν θα είναι τέλειες, είναι προφανές. Αν είναι όμως καλύτερες από την τρέχουσα κατάσταση, τότε νομίζω ότι οφείλουμε να τις εξετάσουμε».

Δεν υπάρχουν σχόλια:

Δημοσίευση σχολίου